Fem spådommer om Data Engineering

Løsningsarkitekt Kim Arthur Sakariassen og senior dataingeniør Ken Tore Tallakstad i Atea Consulting har sett inn i glasskula og spår hvilke trender de tror vil dominere innen Data Engineering i årene som kommer.

Ser vi på hvordan Data Engineering ble beskrevet for fem år siden, sammenliknet med i dag, så ser vi at det i begge tilfeller handler om å hente ut verdifull informasjon fra store datastrømmer. Forskjellen er at vi stadig finner smartere måter å uthente denne informasjonen på. I dag skal dataingeniørene helst være multikunstnere som både forstår verdien av dataen – og vet hva som skal til for å utnytte dataen.

Sakariassen og Tallakstad spår hvilke trender de tror vil dominere innen Data Engineering de neste årene:

Fremtiden i skyen

En av de største trendene i 2022 er at skyen tar over – og dette kommer bare til å fortsette. For fem år siden var «big data» det store buzzordet, fordi man slet med å håndtere lagring og prosessering av store datamengder. I dag anses dette som løst med sømløs skalering i sky.

Løsningsarkitekt Kim Arthur Sakariassen

Datasikkerhet

Økende mengder data og et stadig strengere lovverk rundt bruk av denne dataen (GDPR), fører til et større behov for å strukturere informasjonen. Det inkluderer et økende fokus på sikkerhet og personvern, som også er et område som kommer til å stå stadig mer sentralt i årene som kommer. Når data fra både interne og eksterne kilder samles inn og deles, stilles strengere krav til sikkerhet og personvern enn det som har vært alminnelig praksis frem til i dag.

Mange organisasjoner er i endring for å tilpasse seg en teknologisk utvikling som skjer i et høyt tempo. Innsamling av stadig større mengder data kan komme i konflikt med reglene for håndtering av sensitive personopplysninger. For eksempel kan informasjon om svinn i en butikk bidra til å tegne et systematisk bilde av økt svinn når en bestemt ansatt er på jobb. Slike opplysninger må håndteres varsomt av dataingeniørene som strukturerer dataene, slik at de ikke kan misbrukes av sluttkunden.

Sanntidsanalyser

Tradisjonelle analyse- og databehandlingssystemer er batch-orienterte, det vil si at data samles inn og transformeres i bolker én eller to ganger i døgnet. Fremover vil sanntidsoverføringer mellom ulike systemer bli stadig mer vanlig. Årsaken er behovet for å vite hva som skjer akkurat nå, og ikke i går. Automatisering av hendelser basert på data vil sannsynligvis bli mye mer utbredt i årene som kommer. Å være datadrevet kan for eksempel innebære at roboter fanger opp data og agerer basert på maskinlæringsprosesser som reagerer automatisk på informasjon i kildedataene. Sanntidsinformasjon fører til at behovet for data og hvordan de blir prosessert endrer seg.

De aller fleste bedrifter er i ferd med å bli dataselskaper, selv om kjernevirksomheten i utgangspunktet ikke er teknologidrevet. Sanntidsanalyser kommer til å bli tatt i bruk av stadig flere selskaper fordi muligheten til å ta beslutninger basert på sanntidsanalyser gjør dem mer fleksible og proaktive.

Datavask for god datakvalitet

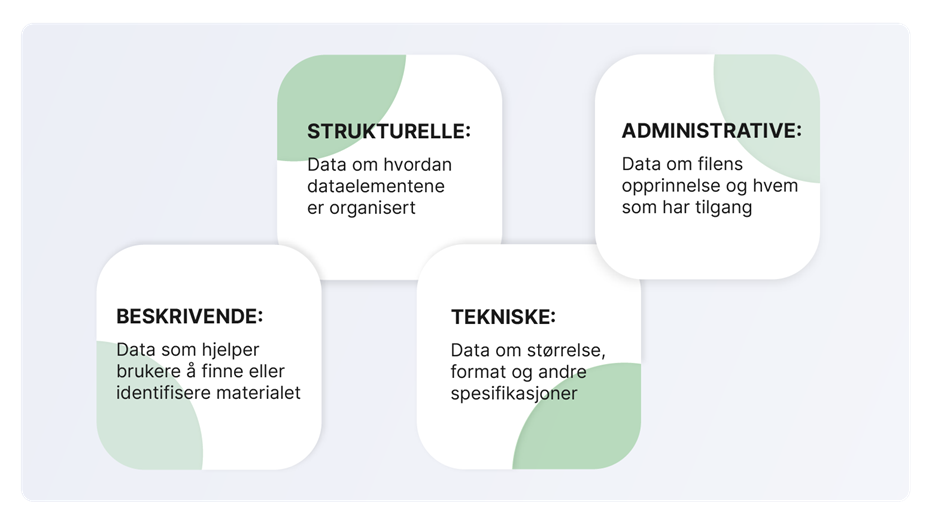

Det er i dag en tilnærmet eksponentiell vekst av ulike datakilder som samles. Det er viktig å vite hva slags data man sitter på, hvor de er lagret og hvordan de skal brukes. Data uten beskrivelse har liten verdi. Det er derfor viktig å ha kontroll på metadataen, siden den inneholder informasjon om hvor dataen kommer fra. Det er «dataen om dataen». Metadata deles gjerne inn i ulike kategorier: Beskrivende, administrative, strukturelle og tekniske.

Når du tar et bilde med telefonen, lagres mengder med metadata i bildefilen. Opplysninger om når og hvor bildet ble tatt, hva slags telefon som ble brukt, i hvilken oppløsning, hvilket motiv og så videre. Dette er eksempler på metadata som gjør det enklere for deg og ulike algoritmer når du skal finne igjen akkurat det bildet.

Dårlig datakvalitet, både på metadataen og dataen i seg selv, er en utfordring for mange. Å kunne ha tillit til dataen er derfor et nøkkelord for suksess. Vi ser at en trend er at man legger ned et stadig større arbeid med datavask for å bedre kvaliteten, slik at informasjonen har større nytteverdi.

Les mer om verdien i metadata og hvordan Data Engineering kan være nyttig for deg.

Fremtidens kompetanse

Nye bruks- og analysekrav som «klikk og pek»-applikasjoner gjør at standardiserte batch-orienterte måter å hente ut data på ikke lenger fungerer like godt. Fremover vil behovet for å programmere dataflyter øke. Nye og standardiserte verktøy for slike prosesser vil fortsette å komme på markedet. Innen teknologi skjer utviklingen i et rivende tempo – det gjelder derfor å henge med.

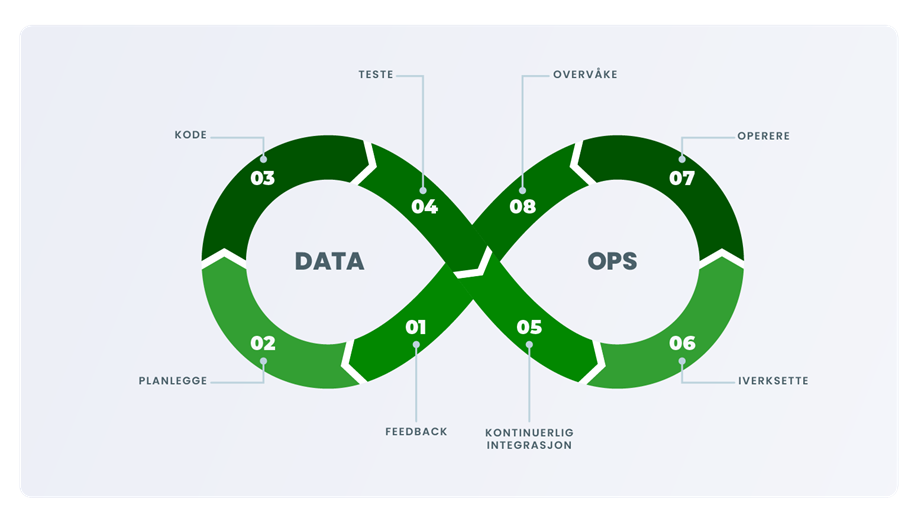

DataOps er et relativt nytt buzzord, og henviser til et rammeverk som gjør datahåndteringen i selskaper enklere. Den raske utviklingen og voksende datastrømmer gjør at stadig flere selskaper søker bistand eksternt for å håndtere all informasjonen. Bevisstheten rundt hva dataingeniører kan bidra med øker, også i bransjer som tradisjonelt ikke har vært spesielt datadrevne.

Som følge av det søker flere selskaper nye løsninger og systemer for å strukturere dataen. For å bli et datadrevet selskap må du ha kontroll på dataene dine, og kjenne til alle prosessene rundt datahåndteringen. Derfor innfører stadig flere selskaper en ny ledertittel; Cheif Data Officer (CDO). Sannsynligvis vil dette bare bli mer vanlig i årene som kommer.

Det amerikanske konsulentselskapet Gartner definerer DataOps slik: «Samhandlende datahåndteringspraksis fokusert på å forbedre kommunikasjon, integrering og automatisering av datastrømmer mellom databehandlere og datakonsumenter på tvers av en organisasjon».