Data Engineering: Hva innebærer det og hvordan er det nyttig for deg?

De fleste bedrifter har tilgang til enorme mengder data. Systematisert og analysert kan disse gi et bedre grunnlag for beslutninger.

Data Engineering handler om å hente ut verdifull informasjon fra store datastrømmer. Hver eneste digitale operasjon legger igjen dataspor. Strømmen av data som flyter gjennom et selskap kan bli så stor at ordinære programmer og analyseverktøy ikke klarer å håndtere den. Da kommer dataingeniørene inn i bildet. De systematiserer informasjonsstrømmen slik at beslutningstakerne får et bedre utgangspunkt når bedriftens veivalg skal tas. Brukt riktig kan dataene være en gullgruve av informasjon som kan øke selskapets lønnsomhet.

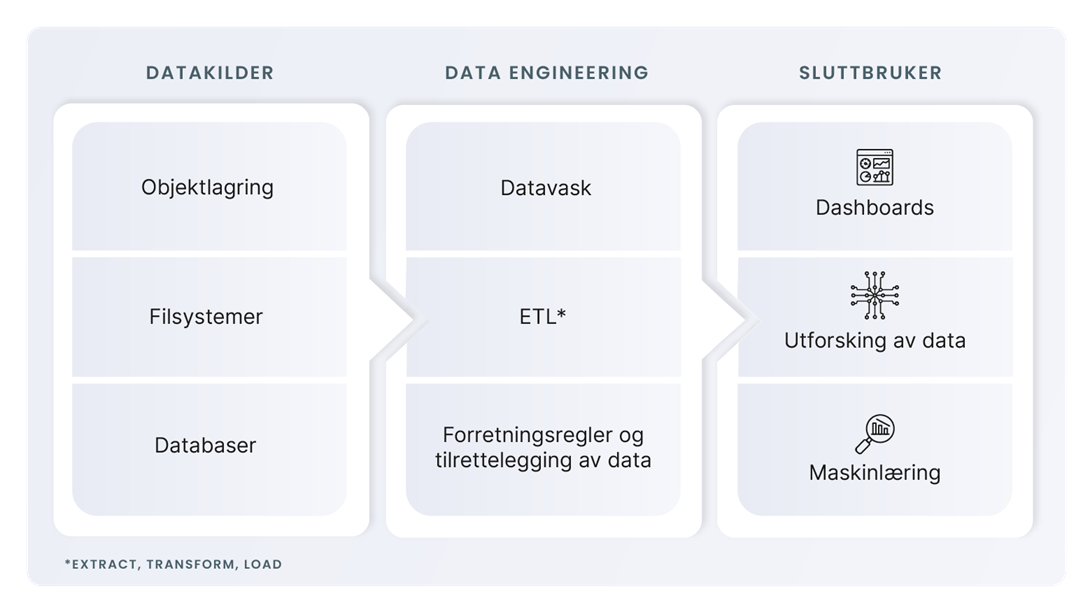

Data Engineering er et sammensatt håndverk som handler om å sørge for at de som tørster etter data skal få dem levert til seg. I rykk og napp eller i en jevn strøm, servert i rå form for egen analyse, eller sammensatt, strukturert og foredlet for innsikt og bruk. Dyktige dataingeniører er ryggraden for å få til en vellykket flyt fra kildenes rådata til sluttbrukers uthenting av data på mange nivåer.

Fra rådata til nyttig informasjon

Rådata kan komme fra egen virksomhet, man kan kjøpe data fra andre, eller det kan være offentlig tilgjengelig informasjon. Gammel og ny data som flyter rundt i en endeløs strøm av informasjon har liten verdi i seg selv. Det er først når informasjonen brukes for å se strukturer og sammenhenger at den blir nyttig.

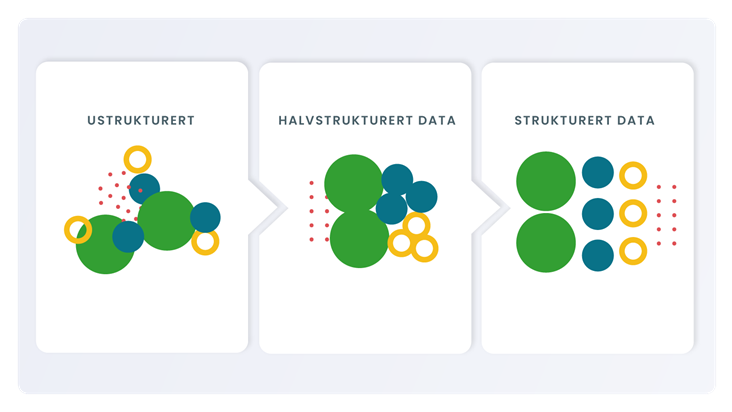

Rådata finnes både i strukturert form (som databaser, Excel-ark, JSON-filer) og halv-/ustrukturert form (som bilder, lyd, bøker og e-poster).

Hvis bedriftens analytikere og markedsførere får tilgang til alle rådataene fra de ulike kildene vil de ikke gi noen mening. Data Engineering er avgjørende for å hente ut verdi. Dataingeniører vet hvordan strukturerte og ustrukturerte rådata i kildene skal lagres for videre bruk, enten det er på interne harddisker eller i skyen.

Verdien i metadata

De siste årene har metadata blitt stadig mer utbredt. Det er informasjon om hvor ustrukturerte data stammer fra. Metadata kan for eksempel si noe om hvem som har tatt et bilde, når det ble tatt, om bildet viser landskap eller personer, hva slags kvalitet bildet har – og så videre. Det gjør det enklere å lete etter de bildene man har behov for.

På samme måte kan metadata fortelle hvor tallene i en tabell kommer fra. Dermed blir det lettere å avgjøre om kilden er til å stole på. I media finnes det flere eksempler på at artikler med tvilsomme kildehenvisninger forplanter seg, fordi journalister hviler seg på saker skrevet av andre. En god dataingeniør haler både kjent og skjult kunnskap ut av dem som har inngående kjennskap til rådataene i kildene.

Maskinlæring og multikunstnere

Dataingeniører skal helst være multikunstnere. De forstår verdien i rådataene fra kildene og vet hvilke data de skal sanke. De kjenner teknikkene for hvordan sankingen skal foregå, slik at den flyter raskt og uten feil. For en avisredaksjon kan det for eksempel være interessant å vite hva som trender på Twitter til enhver tid. Da er det effektivt å følge visse begreper gjennom maskinlæring, som handler om å identifisere mønstre i store mengder data.

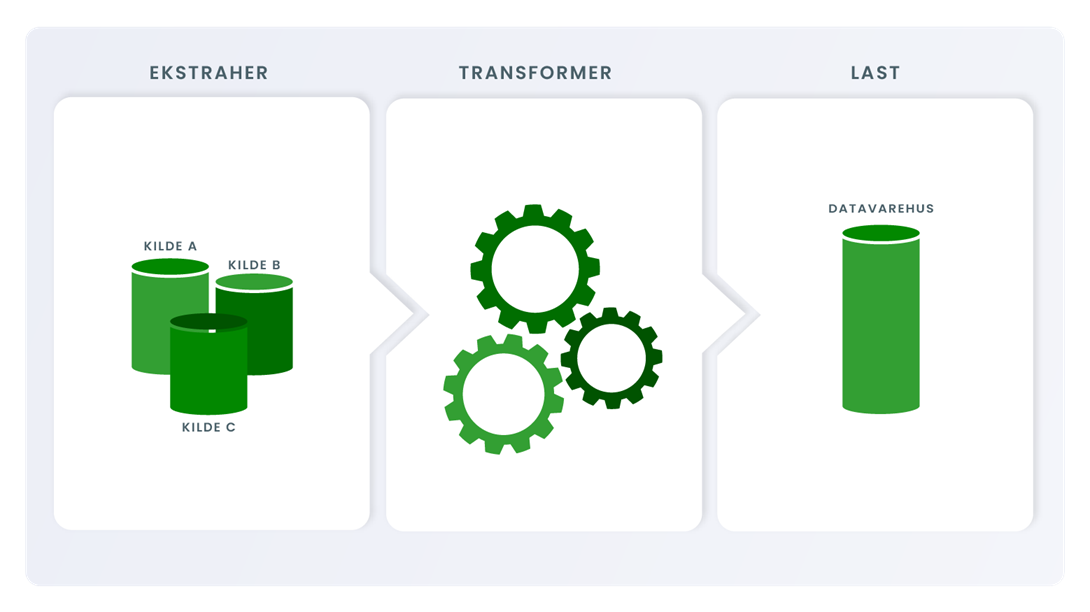

Data Engineering er et IT-fag som krever at dataingeniører må forstå menneskene – både de som produserer dataene og de som skal bruke dem. Når dataingeniørene har identifisert hvilke data som befinner seg i ulike kildesystemer, må de velge metoder for å flytte dem inn i dataplattformen. ETL (Ekstraher, transformer og last) er det klassiske IT-verktøyet, hvor en kjører lastejobber i batch-modus for å hente data fra baser og filer. På veien over omformes dataene til å passe inn i den datamodellen man har valgt å lagre dem i.

Flytting av data og foredling av informasjon

Det finnes en mengde programmer for flytting av data. Kunsten er å vite hvilke programmer en skal velge, og bruke dem riktig. Datamodellering handler om å organisere og strukturere data fra ulike kilder og plassere dem i databaser slik at rapporter og analyser enkelt kan hentes ut på en forståelig måte.

En viktig del av Data Engineering er å sikre at dataene er av god kvalitet. Ofte har kildene ufullstendige data som ikke påvirker funksjonaliteten i kildesystemene, men som kan påvirke bruk av data i andre systemer. En bedrift kan for eksempel gjennomføre en kundeundersøkelse for å få kunnskap til bruk i markedsføring. Hvis svarprosenten er lav vil resultatene imidlertid være verdiløse. På samme måte vil en produktkatalog ha liten informasjonsverdi hvis halvparten av produktene er mangelfullt beskrevet på grunn av dårlige kildedata.

Les mer om fem spådommer for Data Engineering.

Prisvinnende løsning

Vitusapotek er et eksempel på en Atea-kunde som tidligere hadde lite utbytte av rådata fra sine 270 filialer i Norge. Atea startet med å hente inn hver eneste linje fra kassaapparatene, sydde dataene sammen og koblet dem mot produktkataloger og markedsføringstiltak. Når kjeden kjørte en kampanje i media, kunne det påfølgende salget dokumenteres i detalj. Også informasjon om svinn fantes i datakildene, og kunne sammenstilles med når konkrete medarbeidere var på jobb. Slike personsensitive opplysninger må alltid behandles med største varsomhet.

For løsningen Atea laget, vant Vitusapotek BI-prisen Beste praksis, som ble utdelt av Den norske dataforening. «Kandidaten har fått data til å fungere, og effekten er tydelig. Her snakker vi om mersalg, motiverte medarbeidere, trivsel og sunn internkonkurranse. Den norske løsningen blir etterspurt ut over landets grenser og setter selskapet på kartet i en tung internasjonal organisasjon», uttalte juryen.

Sanntidsdata og strømmeplattformer

Batch-orientert teknologi gir selskapene muligheten til å se fortiden klart og tydelig, mens strømming gir dem nåtiden. I noen tilfeller er behovet for hyppig reaksjon i bedriften viktig. Da kan dataingeniøren se på mulighetene for å bygge sanntidsoverføringer. I dag benyttes ofte strømming til slike overføringer. Da sendes hendelser inn på en strømmeplattform som så kan behandle og videreformidle data til for eksempel rapportering.

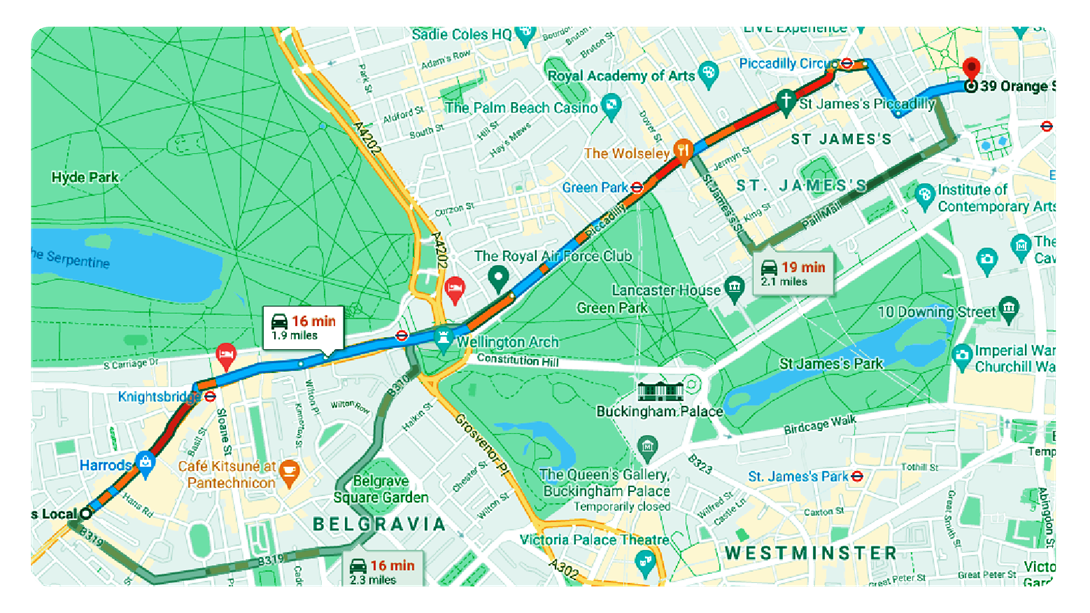

Et eksempel er trafikkinformasjon: Mange bruker Google Maps når de kjører bil, og får oppdatert informasjon om hvor det er kø. Det er informasjon basert på ferske data fra biler som har kjørt foran – som også har vært tilkoblet Google Maps. Hvis bilene kjører under fartsgrensen, vil de som kommer bak få informasjon om kødannelser i sanntid. Et annet eksempel på sanntidsteknologi er jordskjelvdata. Millioner av seismiske sensorer registrerer bevegelser i jordskorpen flere ganger i sekundet og sender av gårde en strøm av data. For seismologene i andre enden blir det rett og slett for mye informasjon å håndtere. Da kan dataingeniører lage et filter slik at seismologene kun blir varslet dersom det skjer noe som bryter mønsteret

Et annet eksempel på sanntidsteknologi er jordskjelvdata. Millioner av seismiske sensorer registrerer bevegelser i jordskorpen flere ganger i sekundet og sender av gårde en strøm av data. For seismologene i andre enden blir det rett og slett for mye informasjon å håndtere. Da kan dataingeniører lage et filter slik at seismologene kun blir varslet dersom det skjer noe som bryter mønsteret